机器学习被公式化为针对给定示例集(训练集)的损失函数的“最小化问题”。 此功能表示由受训练模型预测的值与每个示例实例的期望值之间的差异。

最终目标是教模型具有在训练集中不存在的一组实例上正确预测的能力。

一种可以区分不同算法类别的方法是某个系统的预期输出类型 机器学习.

在主要类别中,我们发现:

分类的一个示例是根据图像中包含的对象或主题为图像分配一个或多个标签;

回归的一个示例是根据彩色图像形式的场景表示来估计场景的深度。

实际上,所讨论的输出的范围实际上是无限的,并且不限于某些离散的可能性。

线性回归是广泛用于估算实际价值的模型,例如:

并遵循连续变量的标准:

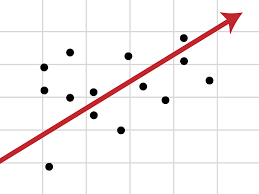

在线性回归中,自变量和因变量之间的关系后接一条通常代表两个变量之间关系的线。

拟合线称为回归线,并由Y = a * X + b类型的线性方程表示。

该公式基于内插数据,以将两个或多个特征彼此关联。 当您为算法提供输入特征时,回归将返回另一个特征。

当我们有多个独立变量时,我们将采用多元线性回归,并假设模型如下:

y=b0 + B1x1 + B2x2 +…+ Bnxn

基本上,该方程式解释了连续因变量(y)与两个或多个自变量(x1,x2,x3…)之间的关系。

例如,如果我们要考虑发动机功率,汽缸数和燃料消耗来估算汽车的二氧化碳排放量(因变量y)。 后面这些因素是自变量x2,x1和x2。 常数bi是实数,称为模型的估计回归系数,Y是连续因变量,即b3,b0 x1,b1 x2等的总和。 y将是一个实数。

多元回归分析是一种用于确定自变量对因变量的影响的方法。

了解因变量如何随自变量变化而变化,使我们能够预测实际情况中变化的影响或影响。

使用多元线性回归,可以了解血压如何随着体重指数的变化而变化,并考虑到诸如年龄,性别等因素,从而假设会发生什么。

通过多元回归,我们可以估算价格趋势,例如石油或黄金的未来趋势。

最后,多元线性回归在机器学习和人工智能领域越来越引起人们的兴趣,因为即使在要分析的记录很多的情况下,多元线性回归也可以获取执行学习模型。

Logistic回归是一种统计工具,旨在用一个或多个解释变量对二项式结果进行建模。

它通常用于二进制问题,其中只有两个类,例如“是”或“否”,“ 0”或“ 1”,“男”或“女”等。

以此方式,可以描述数据并解释二进制因变量与一个或多个名义或序数无关变量之间的关系。

结果是通过使用逻辑函数来确定的,该函数估计概率,然后 defi结束与所获得的概率值最接近的类别(正或负)。

我们可以考虑将逻辑回归作为对家族的分类的一种方法 监督学习算法.

使用统计方法,逻辑回归可以生成结果,该结果实际上代表给定输入值属于给定类别的概率。

在二项式逻辑回归问题中,输出属于一类的概率为P,而输出属于另一类1-P(其中P是0到1之间的数字,因为它表示概率)。

二项式逻辑回归在所有我们要预测的变量都是二进制的情况下均能很好地工作,也就是说,它只能采用两个值:代表正类别的值1或代表负类别的值0。

逻辑回归可以解决的问题示例如下:

使用Logistic回归,我们可以进行预测分析,从而测量我们想要预测的变量(因变量)与一个或多个自变量(即特征)之间的关系。 概率估计是通过逻辑函数完成的。

随后将概率转换为二进制值,并且为了使预测成为真实,根据结果是否接近该类本身,将该结果分配给它所属的类。

例如,如果逻辑函数的应用返回0,85,则表示输入通过将其分配给类别1来生成一个正类别。相反,如果它已获得诸如0,4或更一般地<0,5的值..

逻辑回归使用逻辑函数来评估输入值的分类。

逻辑函数(也称为Sigmoid)是一条曲线,它能够获取任意数量的实际值并将其映射到介于0和1之间的值(极值除外)。 该函数是:

其中:

Logistic回归使用方程式表示,非常类似于线性回归

使用权重或系数值对输入值(x)进行线性组合,以预测输出值(y)。 与线性回归的主要区别在于,建模输出值是二进制值(0或1),而不是数字值。

这是一个逻辑回归方程的示例:

y = e ^(b0 + b1 * x)/(1 + e ^(b0 + b1 * x))

在哪里:

输入数据中的每一列都有一个相关的b系数(恒定的实数值),必须从训练数据中学习。

您将存储在内存或文件中的模型的实际表示形式是方程式中的系数(β或b值)。

Logistic回归对默认类别的概率进行建模。

例如,假设我们正在根据人们的身高将人们的性别建模为男性或女性,第一类可能是男性,而逻辑回归模型可以写为给定一个人的身高或更高的男性概率。正式地:

P(性别=男性|身高)

换句话说,我们正在对输入 (X) 属于 pre 类的概率进行建模definite(Y = 1),我们可以将其写为:

P(X)= P(Y = 1 | X)

为了实际进行概率预测,必须将概率预测转换为二进制值(0或1)。

Logistic回归是一种线性方法,但是使用Logistic函数可以转换预测。 这样的影响是我们不再像线性回归那样将预测理解为输入的线性组合,例如,从上面继续,该模型可以表示为:

p(X)= e ^(b0 + b1 * X)/(1 + e ^(b0 + b1 * X))

现在我们可以按如下方式反转方程式。 要反转它,我们可以通过在另一侧添加自然对数的方式来消除一侧的e。

ln(p(X)/ 1-p(X))= b0 + b1 * X

这样,我们得到一个事实,右边的输出的计算又是线性的(就像线性回归一样),左边的输入是默认类的概率的对数。

概率被计算为事件概率除以无事件概率的比值,例如 0,8 /(1-0,8)其结果为4。因此我们可以改写为:

ln(奇数)= b0 + b1 * X

由于概率是对数转换的,因此我们将其称为左侧对数或概率。

我们可以将指数返回右侧,并将其写为:

概率= e ^(b0 + b1 * X)

所有这些都有助于我们理解,模型确实仍然是输入的线性组合,但这种线性组合指的是前类的对数概率defi妮塔。

在学习阶段估计逻辑回归算法的系数(β或b值)。 为此,我们使用最大似然估计。

最大似然估计是多种机器学习算法使用的学习算法。 模型得出的系数预测预课的值非常接近 1(例如男性)defi晚上,另一个班级的值非常接近 0(例如女性)。 逻辑回归的最大似然是查找系数值(Beta 或 ob 值)的过程,该值可最小化模型预测的概率相对于数据中的概率的误差(例如,如果数据是主要类,则概率为 1) 。

我们将使用最小化算法为训练数据优化最佳系数值。 这通常在实践中使用有效的数值优化算法来实现。