ये तंत्र एक बुद्धिमान मशीन को समय के साथ अपनी क्षमताओं और प्रदर्शन में सुधार करने की अनुमति देते हैं, कुछ कार्यों को करने के लिए अनुभव के साथ स्वचालित रूप से सीखते हैं, समय के साथ इसके प्रदर्शन में सुधार करते हैं।

एक उदाहरण है AlphaGo, गो गेम के लिए मशीन लर्निंग सॉफ्टवेयर द्वारा विकसित किया गया है Deepmind. एल्पागो पहला सॉफ्टवेयर था जो एक हवाई जहाज पर खेल में मानव गुरु को हराने में सक्षम था गोबन मानक आकार (19 × 19)। अल्फ़ागो सॉफ़्टवेयर को विभिन्न खेलों के दौरान गो खिलाड़ियों द्वारा की गई लाखों चालों को देखकर और मशीन के अपने खिलाफ खेलने के द्वारा शिक्षित किया गया था, जिसके परिणामस्वरूप यह इस गेम की दुनिया में सर्वश्रेष्ठ खिलाड़ी माने जाने वाले को हराने में सक्षम था।

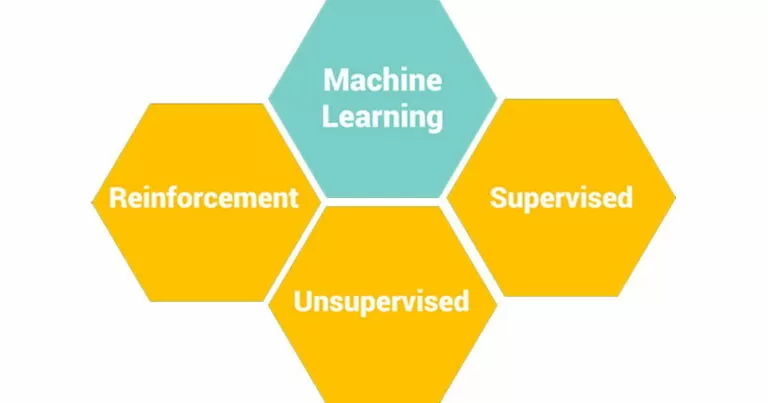

आइए अब मशीन लर्निंग की तीन मुख्य श्रेणियों में जाते हैं।

सिस्टम वांछित आउटपुट के अनुसार लेबल किए गए उदाहरण प्राप्त करता है। अर्थात्, मशीन को निर्देश देने के लिए उपयोगी डेटासेट उन तत्वों से बने होते हैं जो इनपुट डेटा से बनी वास्तविक स्थितियों का प्रतिनिधित्व करते हैं "विशेषताएं"और आउटपुट डेटा से"लक्ष्य". लेख के उदाहरण के संदर्भ में मशीन लर्निंग क्या है, यह क्या है और इसके लक्ष्य क्या हैं?, प्रशिक्षण की तैयारी पर्यवेक्षित प्रकार की थी क्योंकि हमारे पास मार्गों के अलग-अलग मामले थे, जिनमें से प्रत्येक के लिए सुविधाएँ (वाहन, मार्ग) और लक्ष्य (यात्रा का समय) निर्दिष्ट किया गया था। पर्यवेक्षित मशीन लर्निंग की समझ को सरल बनाने के उद्देश्य से डेटा सेट आमतौर पर बहुत अधिक जटिल होते हैं, उदाहरण बेहद सीमित और उपदेशात्मक था।

इस प्रकार का एक मामला एल्गोरिदम को मार्ग और वाहन के प्रकार के आधार का अध्ययन करने की अनुमति देता है, यात्रा का समय क्या हो सकता है। पर्यवेक्षित मशीन लर्निंग में दो प्रकार की समस्याएं होती हैं:

मोटरमार्ग मार्गों के उदाहरण पर पुनर्विचार करते हुए, हम कह सकते हैं कि यह एक प्रतिगमन है। यदि लक्ष्य में एक आकलन शामिल है जैसे: एक घंटे से कम तेज, 1 और दो घंटे के बीच धीमा, दो घंटे से अधिक होने पर बहुत धीमा। इस मामले में यह एक वर्गीकरण समस्या होती।

कोई लेबल वाला डेटा नहीं है, यह वह प्रणाली है जो इनपुट से शुरू होकर डेटा में एक संरचना ढूंढती है। हमारे पास व्यावहारिक रूप से कोई लक्ष्य नहीं है, लेकिन केवल इनपुट डेटा है। जैसे कि उदाहरण में हमारे पास केवल मार्ग और वाहन डेटा था, लेकिन यात्रा समय डेटा नहीं था।

इस दृष्टिकोण में, एल्गोरिदम को डेटा में छिपी संरचनाओं की तलाश करके श्रेणियों की पहचान करनी चाहिए। मुख्य उपकरण जो अप्रशिक्षित दृष्टिकोण में उपयोग किए जा सकते हैं, वे हैं: गुच्छन और संघ के नियम.

सिस्टम पर्यावरण से इनपुट प्राप्त करता है और कार्रवाई करता है। सिस्टम पुरस्कार प्राप्त करने के लिए कार्रवाई करने का प्रयास करता है। सिस्टम उन कार्यों को लागू करने का प्रयास करेगा जो आसपास के वातावरण की स्थिति के आधार पर इनाम को अनुकूलित करते हैं।

इनाम प्रणाली को एक घटक के माध्यम से कार्यान्वित किया जाता है, जिसे कहा जाता है एजेंट. एजेंट पर्यावरण पर की जाने वाली कार्रवाई का फैसला करता है और इससे उसे एक प्राप्त होता है इनाम और संभवत: शुरू की गई कार्रवाई के परिणामस्वरूप पर्यावरण की स्थिति के बारे में जानकारी।

उदाहरण के लिए, यदि हम शतरंज के खेल को समर्पित एक प्रणाली के बारे में सोचते हैं, तो एजेंट वह घटक है जो चाल तय करता है, पर्यावरण ही खेल है। एजेंट द्वारा किए गए हर एक कदम के परिणामस्वरूप, खेल की स्थिति बदल जाती है (वर्तमान स्थिति के रूप में समझा जाता है, सभी टुकड़ों की स्थिति, प्रतिद्वंद्वी की चाल के परिणामस्वरूप भी), एक प्रतिद्वंद्वी के टुकड़े के रूप में प्रतिक्रिया प्राप्त होती है, इसलिए कदम के लिए एक इनाम के रूप में इरादा। इस तरह एजेंट सीखता है, और खुद को शिक्षित करता है।

इसलिए यह स्पष्ट है कि मशीन लर्निंग के प्रकारों के बीच चुनाव संदर्भ पर निर्भर करता है। यही है, उपलब्ध डेटा और इतिहास होने की संभावना के आधार पर दृष्टिकोण का प्रकार चुना जाता है जिसमें प्रत्येक व्यक्तिगत मामले (इनपुट) की परिस्थितियों का विवरण शामिल होता है, और परिणाम (आउटपुट) भी होता है। तो इस प्रकार के डेटा सेट के साथ, आप पर्यवेक्षित दृष्टिकोण का उपयोग करने के लिए आगे बढ़ सकते हैं।

यदि, दूसरी ओर, आपके पास आउटपुट डेटा (लक्ष्य) को एक प्राथमिकता जानने की संभावना नहीं है, या आप नए लक्ष्यों की खोज करना चाहते हैं, तो इनपुट डेटा के बीच लिंक की पहचान करना आवश्यक है ताकि ऐसी परिस्थितियों का पता लगाया जा सके जो कभी अनुभव नहीं हुई हैं। इतिहास, या एक ऐसे वातावरण के प्रति सीखने का सामना करने के लिए जो विकसित और प्रतिक्रिया करता है। इस मामले में असुरक्षित या सुदृढीकरण तकनीकों का चयन करना आवश्यक है।

Ercole Palmeri: नवाचार आदी

लाखों लोग स्ट्रीमिंग सेवाओं के लिए मासिक सदस्यता शुल्क का भुगतान करते हैं। यह आम राय है कि आप...

वीईएम द्वारा कोववेयर साइबर जबरन वसूली घटना प्रतिक्रिया सेवाएं प्रदान करना जारी रखेगा। कोववेयर फोरेंसिक और उपचारात्मक क्षमताएं प्रदान करेगा...

संयंत्र प्रबंधन के लिए एक अभिनव और सक्रिय दृष्टिकोण के साथ, पूर्वानुमानित रखरखाव तेल और गैस क्षेत्र में क्रांति ला रहा है।…

यूके सीएमए ने कृत्रिम बुद्धिमत्ता बाजार में बिग टेक के व्यवहार के बारे में चेतावनी जारी की है। वहाँ…